La performance d’une plateforme en ligne critique relève d’un travail d’ingénierie, pas d’un simple ajout de ressources. Par exemple, choisir un VPS approprié peut être une solution plus efficace. Pourtant, beaucoup de consultants se contentent de recommander l’augmentation de RAM ou de CPU, une solution coûteuse et souvent inefficace lorsqu’elle n’est pas guidée par une analyse technique rigoureuse.

Dans ce cas, une plateforme client d’inscription et de commande à fort enjeu opérationnel était confrontée à un blocage de scalabilité majeur. Le site du client affichait une latence importante, une instabilité récurrente et une incapacité du serveur à absorber le pic des visiteurs le jour du lancement d’une campagne d’inscription pour de nouvelles commandes en ligne.

L’équipe technique de AYRADE a mené un audit complet incluant l’analyse des logs, le profilage des requêtes, la revue des configurations et l’évaluation de la capacité de montée en charge.

Les objectifs étaient clairs : réduire la latence du serveur d’origine, renforcer via un CDN configuré de manière optimale et éliminer les goulets d’étranglement.

Cet article détaille la méthodologie appliquée, les optimisations mises en œuvre, la réduction mesurée de 69 % du temps de traitement par requête, et la validation de la plateforme sous charge avec plus de 96 000 visiteurs uniques simulés, absorbés sans aucune dégradation de service.

Tests de Performance : Diagnostic de la Saturation du Serveur

Nous avons débuté par une analyse en temps réel de la plateforme e-commerce d’inscription et de commande, de notre client :

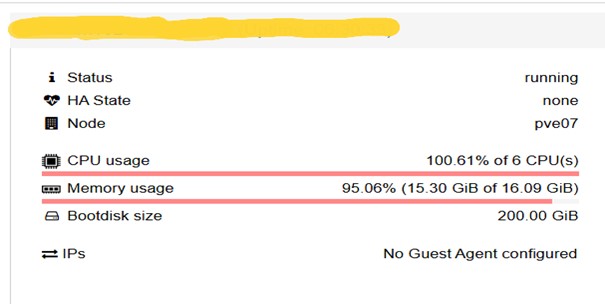

L’examen initial a révélé une consommation sévère des ressources physiques. L’utilisation du CPU atteignait un pic de 100.61% de 6 cœurs, tandis que la mémoire vive (RAM) saturait à 95.06% (15.30 GiB de 16.09 GiB), déclenchant l’utilisation du Swap (mémoire virtuelle sur disque).

L’analyse des processus actifs via la commande de monitoring htop (Sortie de la commande htop, avant optimisation) a révélé une surcharge critique au niveau du Kernel. La visualisation de l’état des ressources montrait les barres de progression de tous les cœurs CPU intégralement remplies et figées au rouge à 100.0%. Ce blocage permanent était causé par des centaines de processus PHP actifs simultanément, chacun monopolisant une part significative du temps de traitement (entre 5.0% et 20.0% des cycles CPU).

L’indicateur le plus éloquent de cette saturation était la Charge Moyenne (Load Average), qui s’élevait à 105.03, 77.10, et 41.21.

Ce Load Average, sur un système à 6 cœurs, démontrait que plus de 105 processus attendaient d’être exécutés, signalant une file d’attente 17 X supérieure à la capacité de traitement immédiate du système. Cette contention du CPU, visible par la consommation totale des cœurs, est le facteur direct de la lenteur observée.

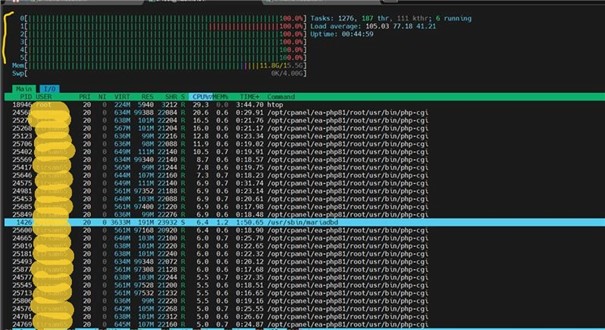

Et pour confirmer notre constat de surcharge et d’épuisement des ressources CPU, l’analyse réseau a révélé une anomalie critique.

L’exécution de la commande netstat a exposé des milliers de connexions TCP en état ESTABLISHED sur le port 443 (HTTPS), provenant de multiples adresses IP.

Cette prolifération de sessions TCP actives était un symptôme direct du goulot d’étranglement du CPU causé par la recompilation PHP : chaque nouvelle requête était mise en file d’attente active plutôt que d’être traitée.

Cette liste de sessions persistantes prouvait que le serveur était submergé. Cet encombrement des connexions réseau confirmait l’incapacité du système à absorber le trafic entrant et à finaliser les sessions HTTP dans des délais acceptables.

La cause racine de cet épuisement était le défaut de configuration du moteur d’exécution PHP : sans l’activation d’OPcache, le serveur était contraint à une recompilation intégrale du code source (fichiers WordPress et extensions) pour chaque requête HTTP avant de pouvoir valider l’intégrité des données critiques.

L’impact direct sur l’expérience utilisateur fut mesuré par un Time to First Byte (TTFB) inacceptable, relevé à 1.2517s.

Quantification de l’Inefficacité par le TTFB

La preuve la plus tangible du goulot d’étranglement côté serveur est la mesure du Time to First Byte (TTFB).

Notre analyse a révélé un TTFB critique à 1.2517s.

Définition et Importance Critique du TTFB : Le Time to First Byte est une métrique de performance fondamentale qui quantifie la latence en millisecondes entre l’émission de la requête HTTP par le client et la réception du tout premier octet de la réponse du serveur. Il est crucial de noter que le TTFB ne représente pas le temps de chargement total de la page (Full Load Time), mais seulement l’étape initiale de traitement par le serveur.

GET https://siteduclient.com/?nocache=1&qm=1 → 200 | TTFB : 1.2517s

Méthode de Mesure : Pour obtenir ce temps de 1.2517s, nous avons utilisé des outils d’analyse de trafic HTTP en forçant une requête sans cache.

Conséquence pour le visiteur : Le TTFB mesuré à 1.2517 Seconde signifie que le visiteur est contraint d’attendre plus d’une seconde avant que le serveur n’ait traité la requête et commencé à envoyer le moindre octet de données. Durant cette seconde, le visiteur ne voit rien se charger (écran blanc ou vide). Le TTFB de 1.2517s est donc un retard initial critique qui s’ajoute ensuite au temps nécessaire pour télécharger et rendre tous les autres éléments (scripts, images) qui constituent la majorité du temps de chargement final de la page web.

Ce résultat a établi que le visiteur était confronté à une latence inacceptable.

Mise en Œuvre de la Solution : Élimination du Goulot d’Étranglement

Qu’est-ce que l’OPcache PHP ?

OPcache est un composant essentiel du moteur PHP, intégré depuis PHP 5.5 , Son objectif est simple: éviter au serveur de recompiler en permanence le code PHP. Sans OPcache, chaque requête oblige PHP à relire les fichiers, analyser le code et générer à nouveau le bytecode avant de l’exécuter. Ce cycle répétitif consomme inutilement du CPU et augmente la latence, en particulier le TTFB.

Avec OPcache, ce fonctionnement change radicalement. Lors de la première exécution d’un script, PHP compile le code source et stocke le bytecode résultant dans une mémoire partagée. À partir de là, toutes les requêtes suivantes accèdent directement à ce bytecode précompilé sans repasser par les étapes de parsing et de compilation. Le serveur élimine ainsi une charge de travail coûteuse et peut répondre plus rapidement, tout en améliorant sa capacité à absorber un trafic important.

Ce mécanisme permet de stabiliser les performances, de réduire l’utilisation des ressources processeur et d’offrir une exécution PHP beaucoup plus réactive. Pour toute plateforme web, OPcache constitue donc une optimisation incontournable du cycle d’exécution PHP.

Comment fonctionne OPcache ?

PHP compile le code source en bytecode lors de la première exécution, le stocke en mémoire partagée, et le réutilise pour toutes les requêtes suivantes sans recompilation.

En termes pratiques, le cycle d’exécution PHP ressemble maintenant à ceci :

Sans OPcache (chaque requête)

1. Lire le fichier PHP depuis le disque

2. Analyser (parser) le code source

3. Compiler en bytecode

4. Exécuter le bytecode

Avec OPcache (première requête)

1. Lire le fichier PHP depuis le disque

2. Analyser le code source

3. Compiler en bytecode

4. Stocker le bytecode en mémoire partagée

5. Exécuter le bytecode

Avec OPcache (requêtes suivantes) :

1. Récupérer le bytecode depuis la mémoire

2. Exécuter le bytecode

Configuration et Tuning de l’OPcache PHP

L’activation de OPcache s’effectue au niveau du fichier de configuration php.ini

Cependant, au-delà de l’activation, nous avons procédé à un tuning de la configuration OPcache afin de maximiser les gains de performance tout en assurant une gestion efficiente des ressources mémoire allouées.

L’implémentation des directives suivantes génère une accélération significative et stabilise le rendement du serveur :

[opcache]

opcache.enable=1 ; Active l’extension OPcache

opcache.memory_consumption=128 ; Alloue 128 Mo de mémoire vive pour le stockage du bytecode

opcache.interned_strings_buffer=8 ; Réserve 8 Mo pour le cache des chaînes de caractères internes

opcache.max_accelerated_files=10000 ; Fixe à 10 000 le nombre maximal de scripts PHP pouvant être mis en cache

opcache.revalidate_freq=60 ; Définit une fréquence de revalidation de 60 secondes pour vérifier les mises à jour

opcache.fast_shutdown=1 ; Optimise la phase de terminaison de chaque requête PHP pour libérer rapidement les ressources

opcache.enable_cli=0 ; Maintient OPcache désactivé pour les exécutions en ligne de commande (CLI)

Cette démarche garantit que le cache PHP est persistant et correctement dimensionné, éliminant ainsi la recompilation coûteuse et améliorant significativement la réactivité du serveur.

Résultat des Performances

| Métrique Critique | Valeur Initiale | Après Activation OPcache | Gain d’Efficacité |

| Page Generation Time (TTFB) | 1.2517s | 0.3864s | -69.1% en temps |

Les requêtes après optimisation sont là où les choses deviennent intéressantes ! L’activation d’OPcache élimine la recompilation PHP.

Maintenant, le comportement système semble très différent. Le TTFB initial chute drastiquement à 0.3864s, car le bytecode est déjà en mémoire. Le CPU reste stable entre 20-40% d’utilisation, Le TTFB est amélioré de 865ms (réduction de 69.1%).

Rôle Technique du CDN : La Seconde Ligne de Défense

Si l’activation d’OPcache a résolu l’inefficacité du cycle d’exécution PHP, une architecture critique destinée à absorber des pics de trafic intenses doit s’appuyer sur une stratégie de distribution. La seconde phase d’optimisation consistait donc à introduire le Content Delivery Network (CDN) pour externaliser la charge statique et sécuriser l’infrastructure.

Le rôle technique principal du CDN est d’améliorer la performance, la disponibilité et la résilience des applications web en distribuant le contenu au plus près des utilisateurs finaux.

1. Amélioration de la Performance (Réduction de la Latence)

Le CDN réduit le temps de chargement des ressources en optimisant le chemin de livraison du contenu :

- Réduction de la Distance Géographique (PoPs) : Au lieu de faire voyager les données depuis un seul serveur d’origine (origin server), le CDN met en cache le contenu sur des Points de Présence (PoPs) répartis mondialement. La requête est dirigée vers le PoP le plus proche de l’utilisateur en termes de réseau (route optimale), minimisant ainsi le temps de vol (Round-Trip Time – RTT).

- Mise en Cache (Caching) : Le CDN gère une couche de cache pour les ressources statiques (images, CSS, JavaScript). Ces ressources sont servies directement depuis le PoP sans solliciter le serveur d’origine, ce qui élimine le traitement côté serveur (réduction du TTFB).

- Compression et Optimisation : Les CDN appliquent souvent des optimisations comme la compression Gzip , l’utilisation du protocole HTTP/2 ou HTTP/3 et la minification des fichiers, accélérant le transfert des données.

2. Externalisation de la Charge (Décharge du Serveur d’Origine)

Ce rôle est critique pour la résilience de l’architecture :

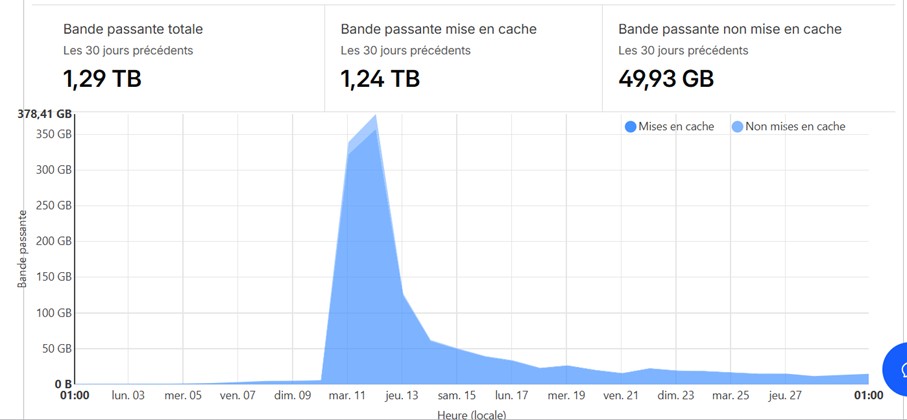

- Gestion du Taux de Réussite du Cache (Cache Hit Ratio) : Un CDN efficace absorbe l’essentiel du trafic. notre analyse montre que 96.12 % de la bande passante a été servie directement depuis le cache.

- Protection contre la Saturation : En déchargeant la majorité des requêtes statiques, le CDN protège le serveur d’origine contre la surcharge de CPU et les goulots d’étranglement réseau, lui permettant de dédier ses ressources limitées uniquement au traitement des requêtes dynamiques non-cachables.

3. Résilience et Sécurité

Le CDN agit comme une couche frontale essentielle pour la stabilité et la sécurité :

- Haute Disponibilité : Si un PoP tombe en panne ou subit une maintenance, le trafic est automatiquement routé vers le PoP le plus proche disponible (failover).

- Atténuation des Attaques DDoS : La capacité distribuée du réseau CDN permet d’absorber des volumes massifs de trafic malveillant (Distributed Denial of Service – DDoS) et d’isoler le serveur d’origine de ces attaques, agissant comme un bouclier.

- Sécurité TLS/SSL : Le CDN gère souvent la terminaison TLS/SSL (chiffrement) au niveau du PoP, soulageant le serveur d’origine de la charge de calcul cryptographique.

En résumé, le CDN transforme une architecture centralisée unique et vulnérable en un réseau distribué résilient et hautement performant.

La Résilience Face au Pic de Trafic

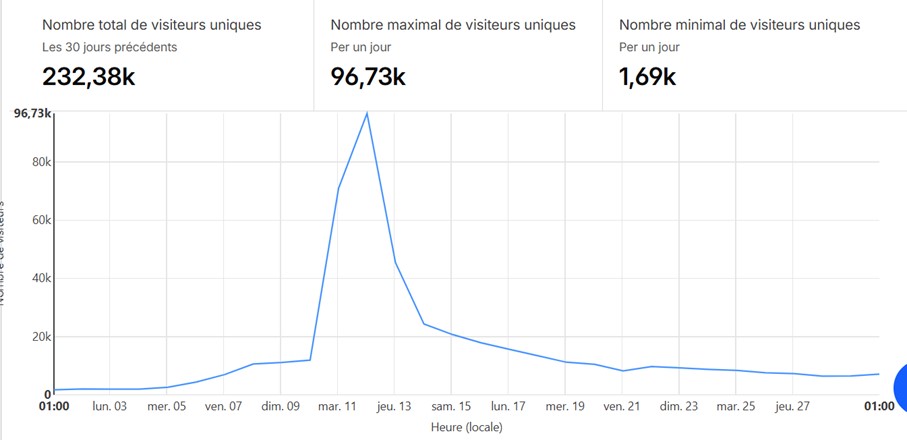

L’efficacité du CDN, combinée à l’optimisation PHP (OPcache), s’est vérifiée de manière efficace lors d’un pic de charge massif sur la plateforme.

- Pic de Visiteurs : Le graphique de trafic montre que le site a réussi à absorber un pic maximal de pratiquement 100 000 visiteurs uniques en une seule journée. Un tel volume aurait inévitablement conduit à une défaillance totale du serveur d’origine non optimisé

- Absorption de la Bande Passante : Ce pic de demande s’est traduit par un volume de bande passante total de 378,41 GB généré sur une seule journée.

- Preuve de l’Externalisation : Malgré cette charge intense, le système est resté stable grâce à l’efficacité du CDN qui a servi 96.12% du trafic total depuis son cache.

Bilan et Stratégie d’Amélioration Continue

Notre intervention avait pour objectif de stabiliser rapidement et efficacement l’architecture le jour même du lancement du client, qui faisait face à une saturation imminente. La correction du cycle d’exécution PHP via OPcache et le déploiement immédiat du CDN ont permis d’atteindre cet objectif, transformant le système en une plateforme résiliente capable d’absorber des pics de trafic massifs.

Latences Résiduelles et Perspective ;

Malgré cette stabilisation critique, le TTFB a été réduit, L’étape suivante de l’ingénierie est le déploiement d’un cache objet persistant (via Redis par exemple ) pour cibler et éliminer ces dernières latences. De plus, une optimisation asynchrone des scripts bloquants garantira que la rapidité du serveur se traduise par un meilleur temps de chargement.

L’équipe AYRADE a ainsi transformé le risque de downtime en une capacité de croissance.

L’Expertise AYRADE : Vers des Architectures Hautes Performances

L’expertise d’AYRADE en ingénierie Cloud permet ses clients non seulement de délivrer des solutions d’urgence efficaces, mais également de concevoir et de déployer des architectures plus complexes et évolutives (microservices, conteneurisation, etc.).

Notre savoir-faire peut être poussé vers des défis technologiques plus exigeants, incluant l’implémentation de solutions d’hébergement performantes et souveraines sur le territoire national, offrant ainsi une garantie de résilience, de sécurité et de faible latence géographique.

Dans le but de vulgariser l’ingénierie Cloud et la performance des systèmes, et de partager les connaissances acquises sur le terrain, nous continuons à publier une série d’articles techniques réguliers. Ces publications visent à décrypter les concepts et à rendre l’optimisation des architectures accessible au plus grand nombre de nos clients.

Si vous recherchez une expertise en ingénierie Cloud et performance pour atteindre une architecture performante et évolutive, consultez nos services.